A medida que los datos electrónicos sobre las personas se vuelven cada vez más detallados y la tecnología permite una recopilación y conservación de estos datos, aumenta la necesidad de una definición de privacidad robusta, significativa y matemáticamente rigurosa, junto con una clase de algoritmos computacionalmente ricos que satisfagan este requisito. El problema del análisis de datos para preservar la privacidad tiene una larga historia que abarca múltiples disciplinas. En particular, ¿cómo publicar datos sobre personas protegiendo su privacidad? Esta pregunta está lejos de ser nueva. Desde la informática se han propuesto muchas ideas creativas intentado responder a esta pregunta durante décadas. Sin embargo, ninguna de ellas fue del todo satisfactoria: se demostró que todas estas ideas se rompían en algunas circunstancias o bien eran difíciles de aplicar sin hacer nula la utilidad de los datos. Esto cambió desde el 2006, cuando cuatro investigadores introdujeron el concepto de privacidad diferencial. Esta nueva noción adoptó un enfoque novedoso, riguroso y fructífero para definir la fuga de privacidad. Entonces, ¿qué hace que la privacidad diferencial sea especial? ¿Cómo tuvo tanto éxito en los círculos académicos? ¿Por qué los gobiernos y las empresas tecnológicas comenzaron a adoptarla para sus publicaciones de datos?

La idea central detrás de la privacidad diferencial

Suponga que tiene un proceso o mecanismo que toma algún conjunto de datos D como entrada y devuelve alguna salida. Este proceso puede ser cualquier cosa, como:

- estadístico ¿cuántos usuarios tienen el pelo rojo?

- de-identificación eliminar nombres y los últimos tres dígitos de los códigos postales

- entrenamiento de un modelo de ML para predecir a qué usuarios les gustan los gatos

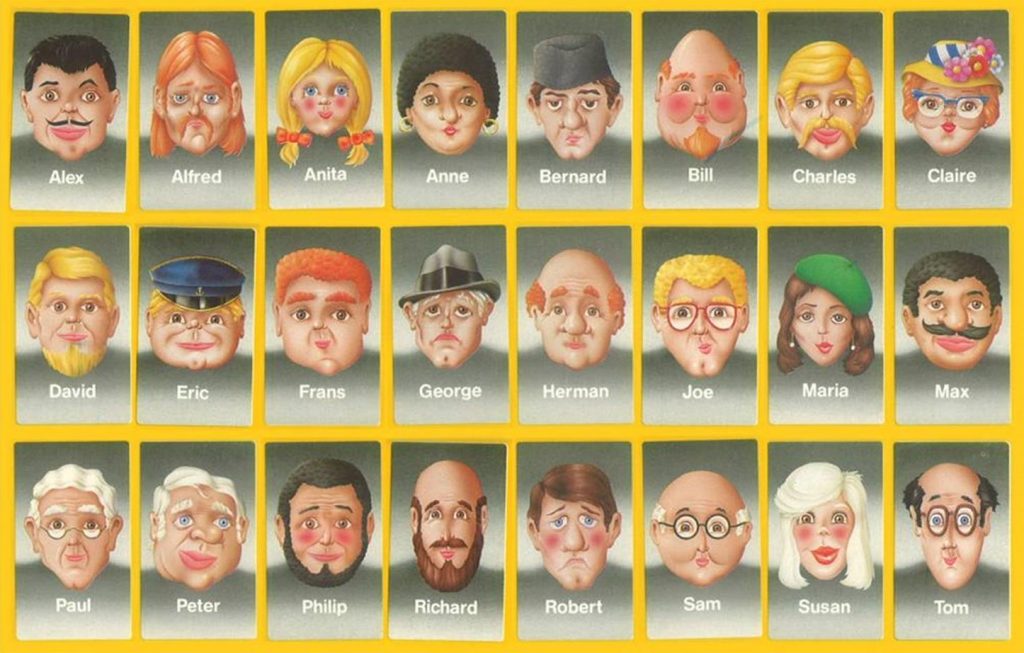

Abordaremos la idea central, usando como excusa un juego en el que se pretende adivinar la identidad basado en una serie de preguntas.

Para hacer que un proceso, o mecanismo, sea diferencialmente privado, generalmente debe incluir algo de aleatoriedad, o ruido, en ciertas partes. Sea M ese mecanismo. Se elimina a algún miembro del conjunto de datos para obtener un nuevo conjunto D‘. Ejecutamos M en ambos conjuntos D y D‘. Si el proceso es diferencialmente privado, entonces aplicarlo sobre D y D‘ dará lugar a dos salidas que serán esencialmente las mismas y esto debe ser cierto sin importar qué miembro de D se haya eliminado para construir D‘ y qué conjunto de datos D se tenía en primer lugar. Por «esencialmente lo mismo», no nos referimos a que «se parecen»; pues teniendo en cuenta que puede haberse agregado algo de aleatoriedad durante el procesos, no siempre obtiene el mismo resultado si ejecuta M varias veces. ¿Qué significa «esencialmente lo mismo» en este contexto? Significa que puede obtener exactamente el mismo resultado en ambos conjuntos de datos con una probabilidad similar.

¿Qué tiene que ver esto con la privacidad? Bueno, supongamos que una persona de dudosa moral intenta averiguar si su persona objetivo se encuentra en los datos originales. Al mirar la salida, no se puede estar 100% seguro de nada. Claro, podría haber venido de un conjunto de datos con su objetivo en ella. Pero también podría haber venido exactamente del mismo conjunto de datos, sin su objetivo. Ambas opciones tienen una probabilidad similar, por lo que no hay mucho que puedas decir.

Esta definición no dice nada sobre cómo se ven los datos de salida, la privacidad diferencial no es una propiedad de la salida per se, sino del proceso que trata al conjunto de datos original para producir dicha salida. Debe saber cómo es el proceso que trata los datos para determinar si son diferencialmente privados.

Encuestas comprometedoras

Si bien entendemos que lo comprometedor está en la respuesta que damos a este tipo de preguntas, intuitivamente tendemos a asociar preguntas comprometedoras con respuestas comprometedoras. El siguiente ejemplo muestra cómo poder evadir esta asociación, utilizando privacidad diferencial.

Supongamos que queremos estimar cuántas personas consumen sus propios mocos. Notemos que si esta pregunta se realiza, llana e ingenuamente, asociando la identidad del encuestado con su respuesta, los resultados no serán fiables. Se propone entonces el siguiente mecanismo para realizar la estimación: los participantes ya no responden directamente a la pregunta, en su lugar, cada uno de ellos lanzará una moneda, sin revelar el resultado al encuestador. El participante realiza los siguientes pasos según obtenga:

cara: contesta la verdad ( sí – no )

cruz: lanzar una segunda moneda y según obtenga cara: contestar sí o cruz: contestar no

El proceso queda ramificado debido al resultado de alguna de las monedas lanzadas. ¿Cómo es que esto conserva la privacidad de las respuestas? Notar que no hay compromiso en las respuestas ya que cuando alguien responde sí, no se tiene certeza de qué rama proviene dicha respuesta. En este sentido el mecanismo o proceso empleado permite aleatorizar la encuesta resguardando la privacidad. A pesar de pretender esconder los resultados la teoría de probabilidades permite extraer una buena estimación del número de personas deseadas a partir de este mecanismo aleatorio M.

¿Qué hace que la privacidad diferencial sea especial?

Este concepto propuesto por primera vez por Cynthia Dwork, Frank McSherry, Kobbi Nissim y Adam Smith en 2006. Muy pronto, casi todos los investigadores que trabajaban en la anonimización comenzaron a construir algoritmos diferencialmente privados. Las empresas tecnológicas y los gobiernos lo están adoptando con rapidez, debido a tres razones principales.

1. No es necesario el modelado de ataque

Las definiciones previas de privacidad requerían hacer algunas suposiciones sobre las capacidades y objetivos del atacante ¿Cuánto conocimiento previo tiene? ¿Qué datos auxiliares pueden usar? ¿Qué tipo de información quieren aprender? Responder a estas preguntas es muy complicado: en particular, es posible que no sepa exactamente lo que el atacante sea capaz de hacer. Peor aún, puede haber incógnitas desconocidas: vectores de ataque que no anticipó en absoluto, se tenían que hacer algunas suposiciones, de las que no se podía estar 100% seguro. Por el contrario, cuando utiliza la privacidad diferencial, obtiene dos garantías extraordinarias:

- Protege cualquier tipo de información sobre un individuo. Si el atacante quiere re-identificar su objetivo, i.e. saber si están en el conjunto de datos o deducir algún atributo sensible. Todas esas cosas están protegidas por definición.

- Funciona independientemente de lo que el atacante sepa sobre los datos. Es posible que ya conozcan a algunas personas en el conjunto de datos. Incluso podrían agregar algunos usuarios falsos a su sistema. Con privacidad diferencial, no importa. Los usuarios que el atacante no conoce aún están protegidos.

2. Permite cuantificar la pérdida de privacidad

La privacidad diferencial, como las nociones anteriores, viene con un parámetro numérico que se puede modificar. Sin embargo, hay una gran diferencia en el significado de ese parámetro. Por ejemplo en k-anonimidad, ¿qué nos dice ese valor k acerca del nivel de protección? La respuesta es «muy poca». No existe un vínculo claro entre el valor de k y qué tan privado es el conjunto de datos. El problema es aún peor con otras definiciones de la vieja escuela. La privacidad diferencial puede cuantificar la información que podría ganar el atacante.

3. Pueden componerse múltiples procesos

Supongamos que tenemos algunos datos y quieres compartirlos con Aurelio y Berta, de forma anónima. Confiamos en A y B por igual, por lo que usas la misma definición de privacidad para ambos. No están interesados en los mismos aspectos de los datos, por lo que se les proporcionan dos versiones diferentes a partir de los datos originales. Ambas versiones son «anónimas», según la definición que haya elegido. ¿Qué sucede si A y B deciden conspirar y comparan los datos que les diste? ¿Seguirá siendo anónima la unión de las dos versiones anonimizadas? Resulta que para la mayoría de las definiciones de privacidad, este no es el caso. Si colocamos dos versiones k-anónimas de los mismos datos juntos, en general el resultado no será k-anónimo. En tal caso, si A y B colaboran, podrían volver a identificar a los usuarios por su cuenta o incluso reconstruir todos los datos originales, lo cual no es una buena noticia respecto de la conservación de la privacidad. Esto puede evitarse con privacidad diferencial, ya que existe una suerte de regla de composición de los procesos: intuitivamente diremos que si el proceso que dió lugar a los datos para A y B son cada uno diferencialmente privados, entonces la unión también lo será. La composición es muy útil en la práctica, pues las organizaciones a menudo quieren hacer muchas cosas con los datos: publicar estadísticas, publicar una versión anónima, entrenar algoritmos de aprendizaje automático. La composición es una forma de mantener el control del nivel de riesgo a medida que aparecen nuevos casos de uso y evolucionan tales procesos.

Reflexión final

El problema de identificar personas detrás de sus datos está regulado por, al menos dos, fuerzas antagónicas. Por un lado, ganaremos protección si conformamos con el resto de personas del conjunto una suerte de hombre-masa común que no tiene partes identificables. Por el otro, la realidad es que anhelamos ser diferentes y destacar entre la multitud.